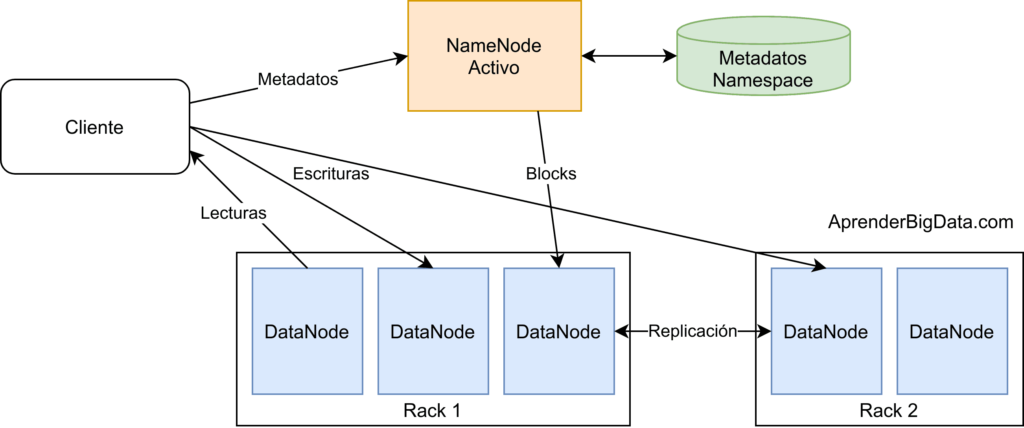

Demonios HDFS (Sistema de archivos distribuidos de Hadoop)

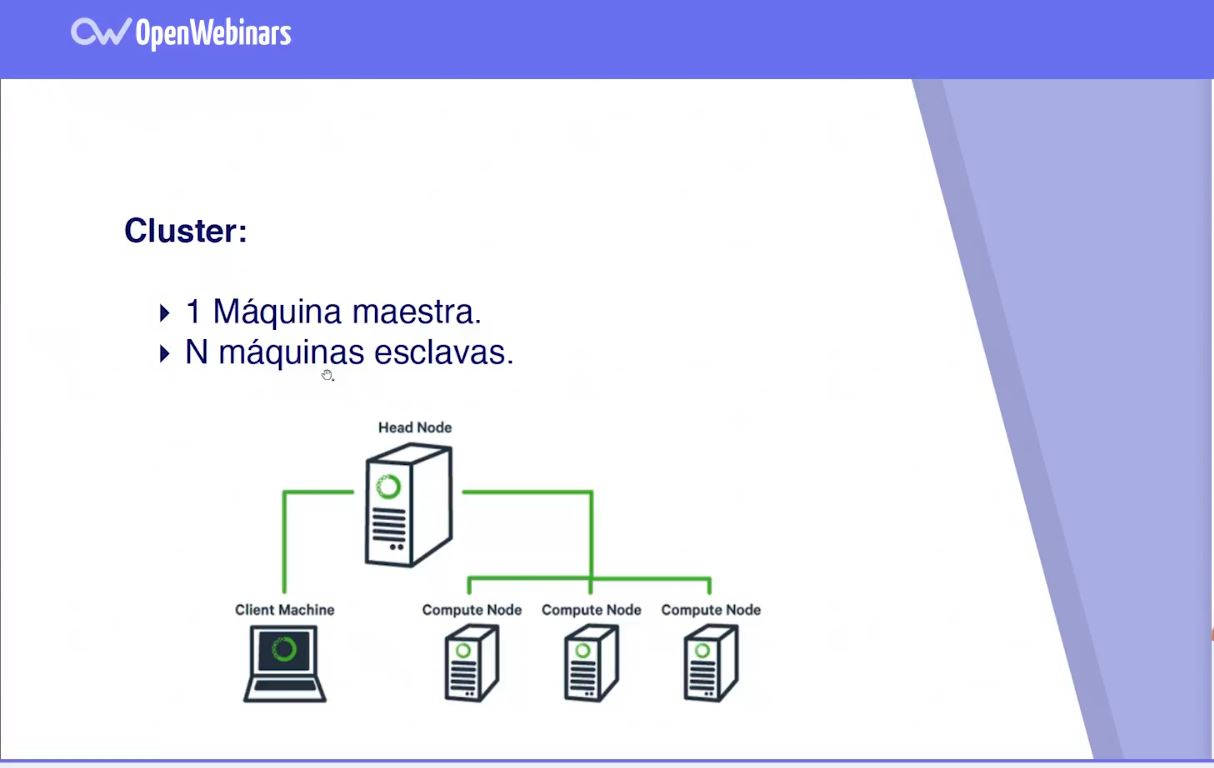

Demonios HDFS (Sistema de archivos distribuidos de Hadoop) es un sistema de archivos distribuido desarrollado por Apache Software Foundation para el almacenamiento de grandes cantidades de datos de forma distribuida en computadoras conectadas a través de una red. Esta tecnología fue diseñada para escalar horizontalmente en lugar de la escalabilidad vertical. Esto significa que el … Leer más