Demonios HDFS (Sistema de archivos distribuidos de Hadoop) es un sistema de archivos distribuido desarrollado por Apache Software Foundation para el almacenamiento de grandes cantidades de datos de forma distribuida en computadoras conectadas a través de una red. Esta tecnología fue diseñada para escalar horizontalmente en lugar de la escalabilidad vertical. Esto significa que el sistema HDFS puede ser expandido simplemente agregando nuevos servidores a la red, en lugar de reemplazar los servidores existentes con nuevas máquinas más poderosas. El sistema HDFS está compuesto por diferentes demonios, cada uno de los cuales desempeña una función específica. Estos incluyen:

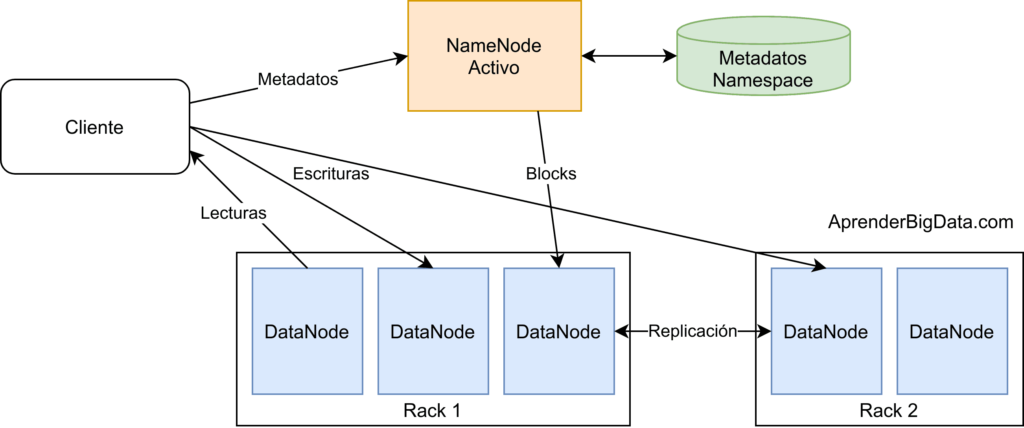

NameNode: El NameNode es el corazón del sistema HDFS. Es responsable de la administración del sistema de archivos, la administración de los bloques de datos y la replicación de los archivos.

Secondary NameNode: El Secondary NameNode actúa como una copia de seguridad del NameNode. Almacena información sobre el estado del sistema de archivos, como los metadatos, y se utiliza como punto de recuperación en caso de que el NameNode falle.

DataNode: Los DataNodes almacenan los bloques de datos del sistema HDFS. Están conectados a un NameNode para recibir instrucciones.

JournalNode: Los JournalNodes almacenan los registros de transacciones de los DataNodes. Estos registros se utilizan para recuperar los datos en caso de que un DataNode falle.

ResourceManager: El ResourceManager es el encargado de administrar los recursos en Hadoop. Se encarga de asignar los recursos a las aplicaciones, así como de supervisar el funcionamiento de los demonios de Hadoop.

¿Qué es HDFS (Sistema de archivos distribuidos de Hadoop)?

HDFS (Sistema de archivos distribuidos de Hadoop) es un sistema de archivos distribuido basado en el software de código abierto Hadoop. Está diseñado para almacenar grandes cantidades de datos en una red de computadoras barata y escalable. HDFS ofrece soporte para un almacenamiento de bloques de gran tamaño, un sistema de replicación de datos para garantizar la disponibilidad de los datos y un sistema de nombres de archivos que permite a los usuarios acceder a sus datos de manera eficiente.

Demonios HDFS (Sistema de archivos distribuidos de Hadoop) son los procesos de trabajo principales en un clúster de Hadoop. Estos demonios se ejecutan en los nodos del clúster y se encargan de administrar los datos almacenados en HDFS. Estos demonios incluyen el NameNode, el SecondaryNameNode, el DataNode y el JournalNode. El NameNode se encarga de administrar el sistema de nombres de archivos HDFS y de mantener una vista global de los datos almacenados en el sistema. El SecondaryNameNode se encarga de hacer copias de seguridad del NameNode. El DataNode se encarga de almacenar los datos y de servirlos a los usuarios. El JournalNode se encarga de mantener los registros de las operaciones realizadas en el clúster.

Ventajas de HDFS

HDFS (Sistema de archivos distribuidos de Hadoop) es un sistema de archivos distribuido que proporciona un almacenamiento de datos escalable, confiable y seguro para el ecosistema Hadoop. Los demonios HDFS se ejecutan en cada nodo de la plataforma Hadoop. El principal demonio de HDFS es el nombre del nodo, que se encarga de administrar el bloque de datos y los metadatos del sistema de archivos.

Ventajas de HDFS:

- Almacenamiento masivo: HDFS permite el almacenamiento de datos masivos en un único sistema de archivos distribuido. Esto significa que el tamaño del sistema de archivos puede escalar a medida que se agregan nodos al clúster.

- Rendimiento: HDFS se diseñó para proporcionar un alto rendimiento en la lectura y escritura de grandes cantidades de datos. Esto se logra mediante el uso de varios demonios HDFS distribuidos a través de un clúster.

- Seguridad: HDFS ofrece un nivel de seguridad robusto mediante el uso de cifrado, autenticación y control de acceso. Esto garantiza que los datos estén protegidos contra el acceso no autorizado.

- Fiabilidad: HDFS se diseñó para ser fiable y seguro. Esto significa que los datos se almacenan de forma redundante para evitar la pérdida de datos en caso de fallo del sistema.

- Escalabilidad: HDFS es escalable, lo que significa que se puede aumentar el tamaño del sistema de archivos sin afectar el rendimiento. Esto se logra mediante el agregado de nodos al clúster.

Desventajas de HDFS

Desventajas de HDFS (Sistema de archivos distribuidos de Hadoop):

HDFS es un sistema de archivos distribuido utilizado por el framework de Hadoop para el almacenamiento de grandes volúmenes de datos. Aunque HDFS ofrece una solución de almacenamiento escalable y confiable para datos masivos, también tiene algunas desventajas.

1. Alto consumo de recursos: HDFS es un sistema de archivos distribuido que requiere una gran cantidad de recursos para funcionar, como memoria, CPU y espacio de disco. Esto significa que el costo de implementación puede ser alto, lo que puede limitar la adopción de HDFS para algunos usuarios.

2. Falta de soporte para archivos pequeños: HDFS está diseñado para procesar grandes volúmenes de datos, por lo que no es bueno para procesar archivos pequeños. Esto significa que los usuarios tienen que dividir los archivos en partes más pequeñas antes de poder procesarlos con HDFS.

3. No es compatible con otras plataformas: HDFS solo es compatible con Hadoop. Esto significa que los usuarios deben usar la plataforma de Hadoop para acceder a los datos almacenados en HDFS y no hay forma de acceder a estos datos desde otras plataformas.

4. Alto tiempo de recuperación: Debido a que HDFS es un sistema de archivos distribuido, puede tardar un tiempo considerable en recuperar los datos. Esto puede ser un problema para aplicaciones que requieren un tiempo de recuperación más rápido.

5. Alta complejidad: HDFS es un sistema de archivos distribuido bastante complicado de configurar y administrar. Esto significa que los usuarios tienen que tener un conocimiento avanzado para poder usar HDFS eficazmente.

Componente principal de Hadoop Daemons

Los Demonios HDFS (Sistema de archivos distribuidos de Hadoop) son un componente principal de los Daemons de Hadoop. HDFS es un sistema de archivos distribuido para almacenar y procesar grandes volúmenes de datos. Está diseñado para soportar grandes volúmenes de datos, y para almacenar y procesar estos datos de forma segura y de alta disponibilidad. HDFS es un sistema de archivos distribuido, lo que significa que los archivos se almacenan en varios nodos en una red. Esto permite que los datos se procesen de forma paralela, aumentando la velocidad de procesamiento.

Los Demonios HDFS se encargan de administrar la replicación de los datos en los diferentes nodos de la red. Esto significa que los mismos datos se almacenan en varios nodos, lo que aumenta la disponibilidad de los datos y garantiza que los datos no se pierdan si un nodo se cae. Los Demonios HDFS también se encargan de administrar el balanceo de carga entre los nodos, lo que significa que los datos se distribuyen de forma equitativa entre los miembros de la red.

Los Demonios HDFS también se encargan de la gestión de los datos. Esto incluye la ejecución de tareas de lectura y escritura de archivos, la administración de la memoria caché y la administración de la conexión entre los diferentes nodos. Esto garantiza que los datos sean almacenados y procesados de forma segura y eficiente.

Los Demonios HDFS son un componente clave para el funcionamiento de Hadoop. Estos daemons se encargan de la administración y el procesamiento de los datos almacenados en la red, lo que asegura que los datos se procesen de forma eficiente y segura.

Funcionalidad de los nodos

Los nodos son los componentes básicos de HDFS, el sistema de archivos distribuidos de Hadoop. Estos nodos se encargan de almacenar, replicar y manejar los datos en el cluster. Estos nodos funcionan como servidores independientes y se encargan de almacenar los bloques de datos y de proporcionar acceso a los datos a los usuarios a través de los demonios HDFS.

Los demonios HDFS son los responsables de la administración de los nodos en el cluster. Estos son los componentes del sistema que permiten la comunicación entre los nodos y los usuarios. Los demonios HDFS se encargan de distribuir los bloques de datos a los nodos, monitorizar el estado de los nodos, detectar y reparar nodos fallidos, etc.

También se encargan de gestionar la replicación de los bloques de datos entre los diferentes nodos para asegurar la redundancia de los datos. Esto significa que si uno de los nodos falla, los datos seguirán estando disponibles, ya que se encuentran replicados en otros nodos.

Los demonios HDFS también se encargan de procesar las peticiones de los usuarios y de encargarse de la administración de los nodos. Esto significa que los usuarios no tienen que preocuparse por la administración de los nodos, ya que esto se realiza de forma automática por los demonios. Esto permite que los usuarios se centren en la tarea de procesar los datos sin tener que preocuparse por la administración de los nodos.

¿Cómo administrar los metadatos del sistema de archivos en detalle?

Administrar los metadatos del sistema de archivos en detalle es una tarea importante para los usuarios de HDFS (Sistema de archivos distribuidos de Hadoop). Los metadatos se almacenan en el nombre del sistema de archivos y se pueden usar para administrar los archivos, directorios y otros recursos del sistema de archivos. Los metadatos contienen información importante acerca de los archivos y directorios del sistema de archivos, como la cantidad de espacio en disco que ocupan, los permisos de acceso, la fecha y hora de la última modificación, etc. Esta información es esencial para el correcto funcionamiento de los demonios HDFS, ya que Ayudan a los usuarios a encontrar, recuperar y administrar los archivos.

Los metadatos también contienen información sobre los procesos de replicación y reubicación de los archivos en el sistema de archivos. Esta información es esencial para la configuración y administración de los demonios HDFS. Los metadatos se pueden usar para controlar la cantidad de copias de los archivos que se replican a través de los diferentes nodos del sistema. Esto ayuda a asegurar que los archivos estén siempre disponibles para los usuarios que necesiten acceder a ellos. También se pueden usar para controlar la reubicación de los archivos entre nodos. Esto ayuda a asegurar que los archivos estén siempre almacenados en los nodos más adecuados para su uso.

También hay herramientas de administración de metadatos que permiten a los usuarios ver y editar los metadatos del sistema de archivos. Estas herramientas se pueden usar para verificar la integridad de los metadatos, para asegurarse de que están correctamente configurados. También se pueden usar para realizar tareas de administración, como la creación de nuevos directorios, la modificación de los permisos de acceso y la eliminación de archivos. Estas herramientas ayudan a los usuarios a administrar sus archivos y directorios de manera más eficiente.

En conclusión, administrar los metadatos del sistema de archivos de HDFS es una tarea importante para los usuarios de este sistema de archivos distribuidos. Los metadatos contienen información importante acerca de los archivos y directorios del sistema de archivos y ayudan a los usuarios a encontrar, recuperar y administrar los archivos. Existen herramientas de administración de metadatos que ayudan a los usuarios a verificar la integridad de los metadatos y realizar tareas de administración.

Manex Garaio Mendizabal es un ingeniero de sistemas originario de España, conocido por ser el creador de la popular página web «Sapping». Nacido en 1985, Manex comenzó su carrera en el campo de la tecnología como desarrollador de software en una empresa local. Después de varios años de experiencia en la industria, decidió emprender su propio proyecto y así nació «Sapping». La página web se ha convertido en un referente en el mundo de la tecnología y ha sido utilizada por miles de personas alrededor del mundo. Gracias